机器之心报说念万博max官网

裁剪:Panda、小舟

地球上最早的人命把柄至少不错追猜度 35 亿年前,而直到大致 25 万到 40 万年前,智东说念主才出现地球上。在这漫长的岁月中,生物阻抑地昌盛又衰一火,但举座趋势老是越来越复杂,其中最复杂的生物组件莫过于咱们智东说念主的大脑。这么的复杂性是咱们的意志和聪惠的开头。而这一切背后的机制是进化(evolution)。

到了现今的大模子时期,弘大的基础模子也曾展现出了弘大的智能水平,能完成多各样种的任务。但它们也有个污点,历练之后就基本定型了,难以跟着用户的使用而演进。但毫无疑问,这项材干很进军。

近日,天桥脑科学揣测院和普林斯顿大学等多所揣测机构发布了一篇揣测论文,详备进展了长久追思对 AI 自我进化的进军性,况且他们还暴戾了我方的已毕框架 —— 基于多智能体的 Omne,其在 GAIA 基准上取得了第又名的得益。

论文标题:Long Term Memory : The Foundation of AI Self-Evolution论文地址:https://arxiv.org/pdf/2410.15665

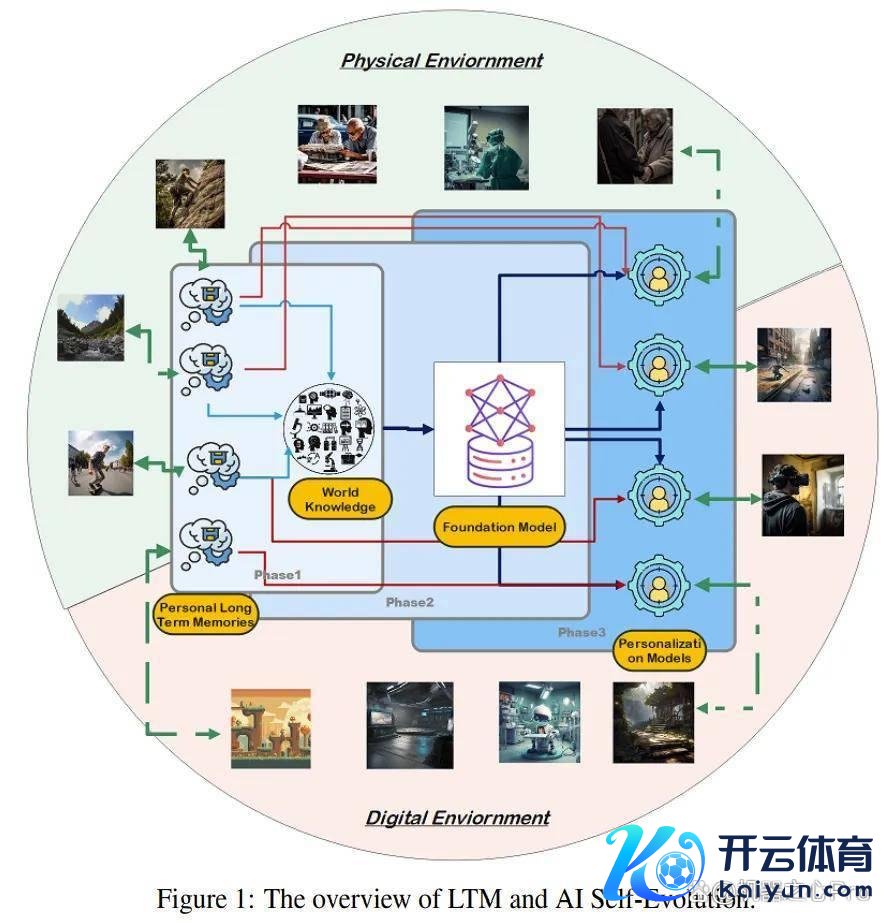

最初,该团队将 LLM 的模子进化经由分红了三个主要阶段

阶段 1:在物理天下中积贮解析。阶段 2:在数字天下中构建基础模子。阶段 3:模子自我进化,以已毕更弘大的智能。

现存的揣测主要围绕着阶段 1 和 2,即怎么构建更好的数据以及将其用于历练更弘大的基础模子。面前东说念主们有一个巨额的看法:在这种弧线拟合范式中,架构并不进军,关键的要素是数据集。但到了阶段 3,架构就会变得和数据不异进军。中枢的难题是如安在统计模子的基础上有用抒发少数个体的数据。该揣测关怀的中枢是怎么确保在统计模子内有用地抒发个体数据。

已毕模子自我进化的旨趣

模子的自我进化材干是模子长久稳当和个性化的关键,而这又严重仰赖于有用的追思机制。

在这一通晓的基础上,该团队暴戾:长久追思(LTM)能为模子的抓续进化提供历史数据积贮和素养学习材干。正如东说念主类通过素养和追思来完善解析和行动不异,LTM 也能让模子在处理长久、分散和个性化的数据时冉冉普及推理和学习材干。

用 LTM 数据普及模子材干,使其大致自我进化

在传统 LLM 中,更新模子时常需要转移扫数参数,而如若目的是处理个体数据,那这种操作显着不切本色。

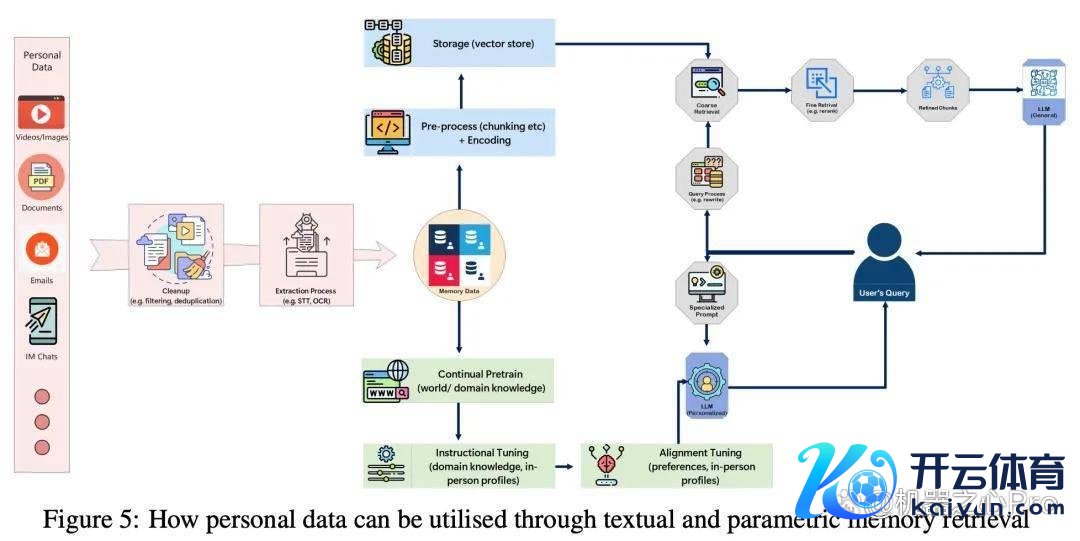

一种更优的步骤是仅更新局部参数,从而在无损模子全局领略性的前提下,让模子稳当疏淡、个性化的 LTM 数据。这种步骤可处分现时模子中个体数据「被平均化」的问题,使个性化信息大致更全面地抒发。使用高下文体习(ICL)的检索增强生成(RAG)和用于微调的低秩稳当(LoRA)等时间都可被视为局部更新个体数据的步骤。

该团队的作念法是采选一种搀和战略来整合 LTM 数据,从而在本色应用中达到让东说念主欣忭的扫尾。但是,该团队也示意,这可能并非一种竣工的处分决策,将来可能还会出现更好的步骤。

组合 LTM 数据进行及时权重更新,从辛勤毕自我进化

现时的 LLM 时常分为历练和推理两个阶段。在推理阶段,模子权重是冻结的,恶臭模子根据新输入进行转移和学习。这种固定的推理经由会端正模子的稳当性,尤其是在处理个性化任务和及时学习方面。

受东说念主脑更新机制的启发,该团队以为将来的 LLM 应该将推理和历练与 LTM 聚拢起来,使模子大致在收受到新信息时动态转移权重。这就肖似于东说念主类的抓续学习材干。

此外,这种集成还不错匡助模子在靠近复杂的推理任务时自我反想并雠校空幻的推理旅途,从而提高准确性和后果。

这种动态的自我转移材干将大大普及模子的个性化材干和长久进化后劲。通过长久追思,模子不仅不错从短期追思中学习,还不错从历史数据中索要有价值的概念,跟着期间的推移能更真切地通晓个东说念主偏好和行动样式。这种通晓可已毕模子的个性化定制和动态转移,使模子大致更有用地进化。绝顶是在靠近新的或顶点的情况时,长久追思使模子大致参考往时的素养,快速作念出转移并自我进化,从而取得更大的天真性和稳当性。

长久追思在模子自我进化中的已毕旅途

该团队最初将给出 AI 自我进化和 LTM 的界说,然后探索 LTM 在 AI 自我进化中的关键作用,之后会先容怎么使用 LTM 来已毕 AI 自我进化。

他们作念出了以下孝顺:

给出了 AI 自我进化和 LTM 的界说;暴戾了一个用于 LTM 的数据框架,包括数据采集、分析与合成;暴戾了一个用于 LTM 的多智能体配合设备框架。

AI 自我进化的基础

这里简要给出 AI 自我进化的界说,确定请参阅原论文。

AI 自我进化是指 AI 模子使用个性化数据阻抑学习和优化,已毕多智能体配合和解析方面的冲突。该经由基于一个分享式内核架构,其中各个模子通过处理个性化素养和数据阻抑进化,从而普及本身推理材干和稳当材干,最终已毕在动态环境中的自主学习和抓续进化。

要已毕 AI 自我进化,需要:

多智能体配合机制各别化的个性化模子自我纠错和评估机制长久追思和学习材干

用于 AI 自我进化的 LTM

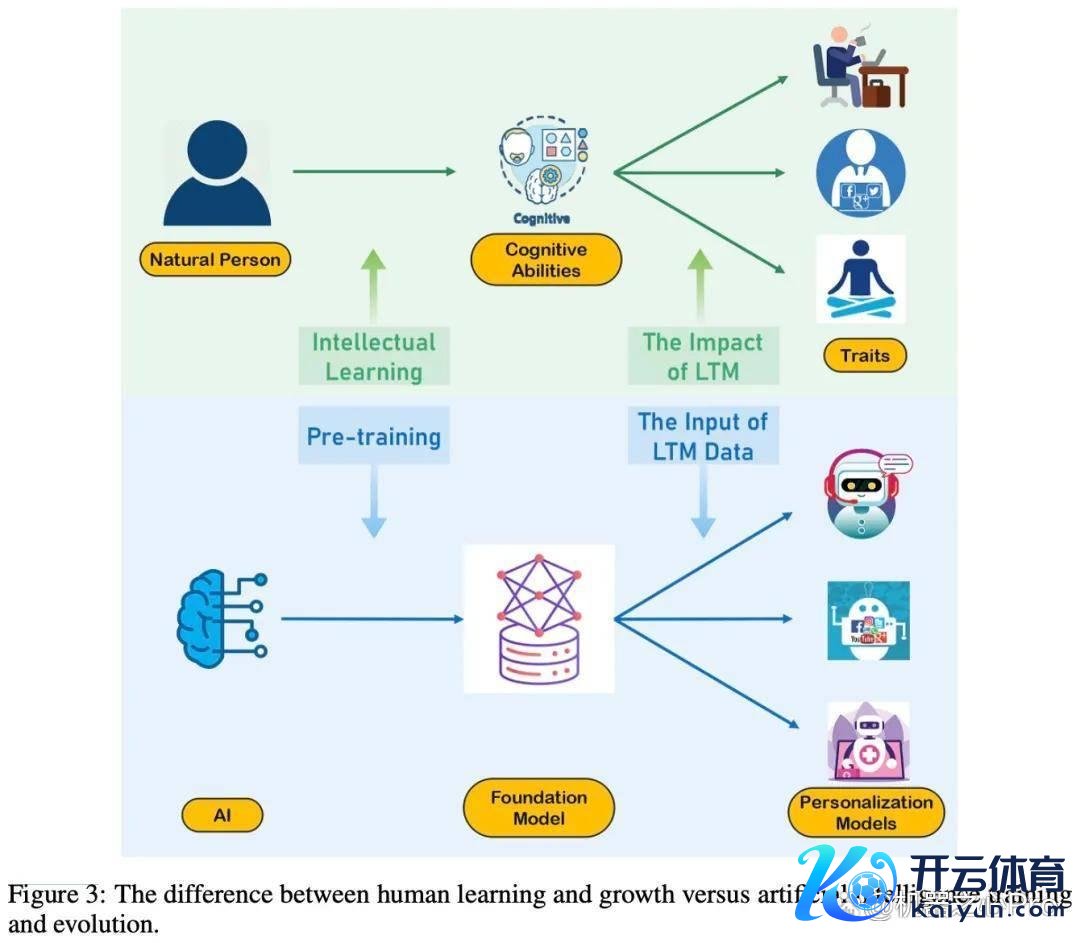

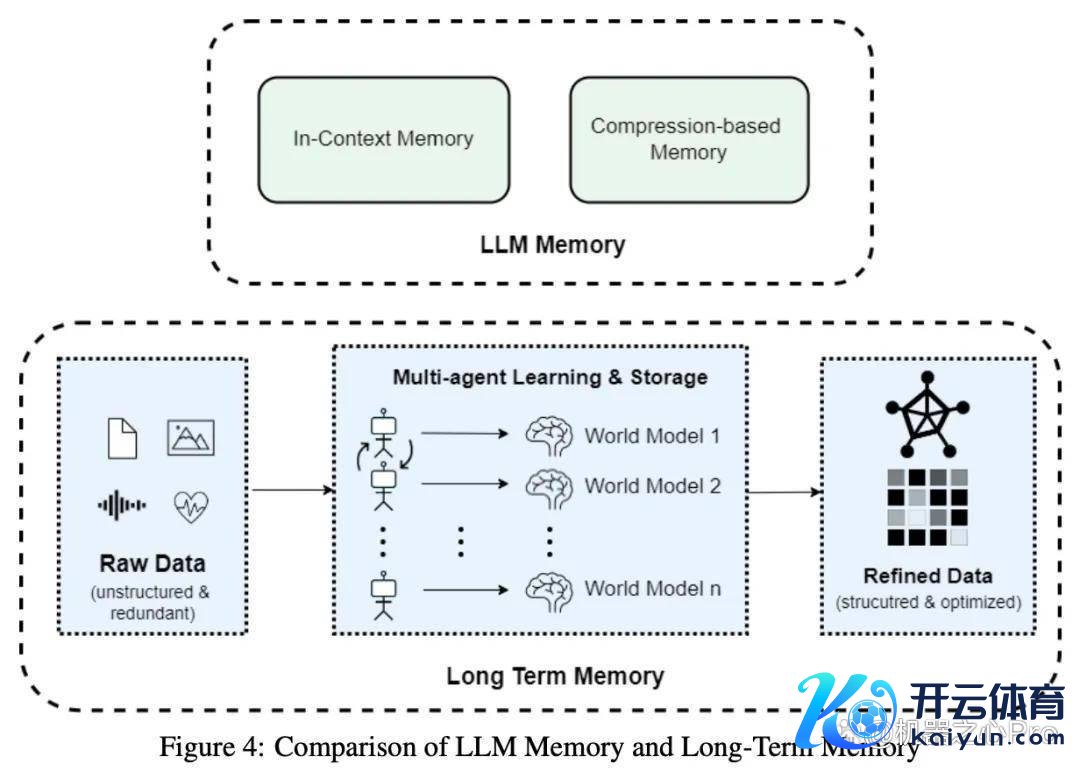

面前,LLM 主要通过两种追思机制来经管信息:高下文存储器和基于压缩的参数存储器。天然这些机制在短期任务中浮现出色,但它们在解救长久自主学习和进化方面仍然存在不及。

正如东说念主类使用 LTM 来塑造他们的行动和身份不异,东说念主工智能系统也不错采选肖似的步骤根据「个东说念主数据」定制其反馈和行动。这里,「个东说念主数据」不仅限于个东说念主用户,还包括特定的机构和领域,允许模子根据更粗犷的个东说念主配景和需求转移其反馈和行动。

作家真切探求了 LTM 在 AI 自我进化中所证明的关键作用,最初在 AI 自我进化的配景下界说了 LTM,并分析了现时 LLM 追思机制的污点。然后,作家接头了通过从东说念主类 LTM 特征中招揽灵感来增强东说念主工智能模子的自我进化材干,旨在构建能抓续学习和自我完善的东说念主工智能系统。

该揣测将 AI 自我进化中的 LTM 界说为:

LTM 是东说念主工智能系统不错长久保留和哄骗的信息,使模子大致根据更粗犷的配景转移其反馈和行动。

这里,「个东说念主数据」不仅限于个东说念主用户,还包括特定的机构和领域,允许模子根据更粗犷的个东说念主配景和需求转移其反应和行动。

从数据积贮的角度来看:模子和东说念主类都与环境进行粗犷的交互,为个性化提供基础数据。与东说念主类比拟,东说念主工智能模子不错更有用地与环境交互,况且不错在纯臆造的数字环境中引申这些交互和迭代。因此,通过瞎想符合的追思细化战略,模子应该大致像东说念主类不异积贮长久追思,以至可能具有更高的后果和限度。

从模子更新的角度来看:东说念主工智能擅长存储和调用海量数据,远远超越东说念主类追思限度。神经汇集通过分散式参数经管这些数据,处理来自不同领域的输入。但是,这种存储相对刚性,空泛及时更新的天真性,时常需要从新历练才能已毕更新。比拟之下,东说念主类的追思力却绝顶强。

LTM 的构建战略

LTM 是对原始数据的有用组织和结构化,而不单是是名义上对原始数据进行分类和排序。违反,它是从追思快速存储和检索以及信息高效哄骗的角度来瞎想和优化。通过成就联系信息之间的联系,有用处理数据并从新组织信息,智能体不错快速定位所需的追思片断,从而提高反馈速率和准确性。以下是几种主要的操作步骤:

文本摘录数据结构化图表征矢量化模子参数化

怎么哄骗 LTM 已毕模子自我进化?

取得高质料的 LTM 数据后,下一个挑战是怎么哄骗它来增强模子材干并已毕模子的自我进化。在使用 LTM 数据以最大端正地提高其有用性和后果的经由中需要处分几个关键挑战,包括:

稳当抓续更新的 LTM 数据。跟着用户 LTM 数据的阻抑积贮,模子必须在学习新信息和保留先前获取的常识之间取得均衡。传统模子时常假定领略的数据分散,但在本色场景中,新的 LTM 数据可能与早期样式权贵背离,导致过拟合或倒霉性淡忘等风险。有用处理这些变化关于稳当动态 LTM 数据至关进军。

及时学习和高效反馈集成。由于 LTM 数据是动态积贮的,模子必须快速稳当用户行动的及时变化。新数据的快速集成关于智能助手等应用尺度至关进军,其中无缝的用户交互是关键。此外,在完善基础模子时,应试虑隐式(举例点击次数或破耗的期间)和显式的用户反馈。及时聚拢这两种类型的反馈使模子大致阻抑创新并知足个东说念主用户的需求。

处理数据疏淡性和用户各样性。数据疏淡是抓续更新的 LTM 系统中一个常见的问题,绝顶是关于交互历史有限或稀疏行动的用户来说,这使得历练模子变得贫窭。此外,用户各样性也会进一步加多复杂性,条目模子稳当个体样式,同期仍然有用地引申到不同的用户组。

以清华大学团队的 Agent Hospital(智能体病院)动作案例,该团队展示了如安在这个模拟医疗场景顶用 LTM 来普及模子的材干,其中包括医疗纪录积贮、医疗素养反想和基于 RAG 哄骗 LTM。详宥恕论文。

基于 LTM 已毕模子自我进化的实践

获取 LTM 数据

为了普及模子保留和探望 LTM 数据的材干,该团队全面揣测了各样步骤,其中包括:

怎么采集确凿天下的 LTM 数据。怎么获取合成的 LTM 数据,其中包括用确凿数据普及合成 LTM 数据的生成经由、使用想维链增强合成 LTM 数据的生成经由、生成历练数据和评估数据等多个方面。怎么使用 LTM 数据,该团队先容了通过 SFT 和 RAG 使用 LTM、将 LTM 用于医疗领域的智能体自我评估、通过追思系统来使用 LTM、通过及时权重更新来使用 LTM。

这其中包含一些实验评估和例证,详宥恕论文。这里咱们来重心望望他们设备的基于 LTM 的多智能体框架。

基于 LTM 的多智能体框架

该团队暴戾一个基于 LTM 的多智能体框架 Omne。

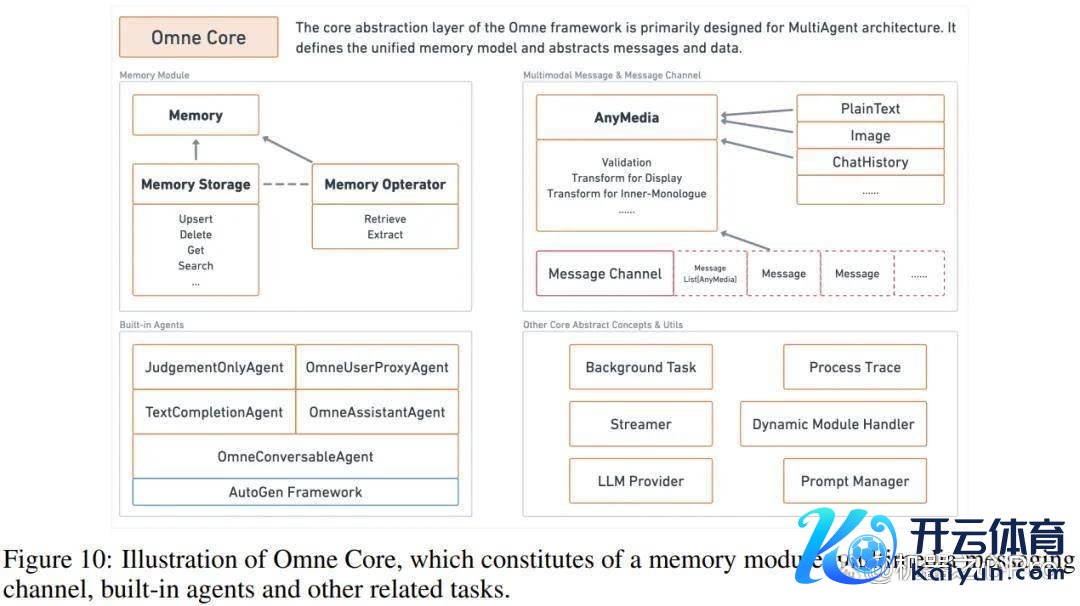

Omne 是基于 AutoGen MultiAgent Framework 深度定制的设备框架,专诚用于处分 LTM 在 AI 系统中的本色应用难题。

它扩张了一系列与追思联系的基础设施,包括调处的追思模子、多模态音信处理系统以及天确实追思存储和操作机制。Omne 的中枢模块(Omne Core)如下图所示:

Omne 的中枢指标是提供一套全面的处分决策,使 LTM 大致在本色工程形势中有用部署,从而增强 AI 系统的长久追思材干和任务处理后果。

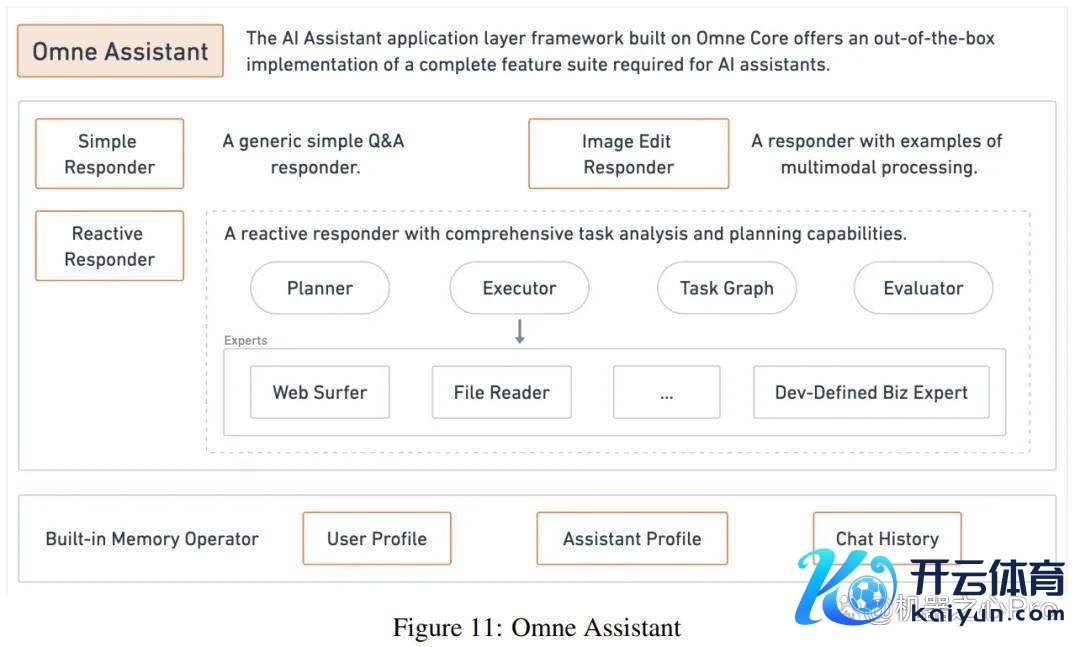

基于 Omne Core,该团队还构建了一个 Omne Assistant。

Omne Assistant 的瞎想指标是匡助设备聊天场景中的 AI 助手,其提供了一个现成的应用层框架。它包括 AI 助手所需的基本功能,使设备东说念主员无需从新运行瞎想基础组件,就能快速构立功能皆全的聊天机器东说念主。

Omne Assistant 带有一个 Simple Responder,这是一个通用的问答反馈器,不错处理基本的用户聊天交互以已毕即时通讯。此外,该框架还提供了一个 Reactive Responder,它具有高等任务分析和策动功能,使其大致经管需要多才略推理和任务编排的更复杂的用户肯求。

借助这些内置组件,Omne Assistant 可闪设备东说念主员专注于已毕我方的功能,从而更快地设备和部署配备长久追思功能的 AI 助手应用。

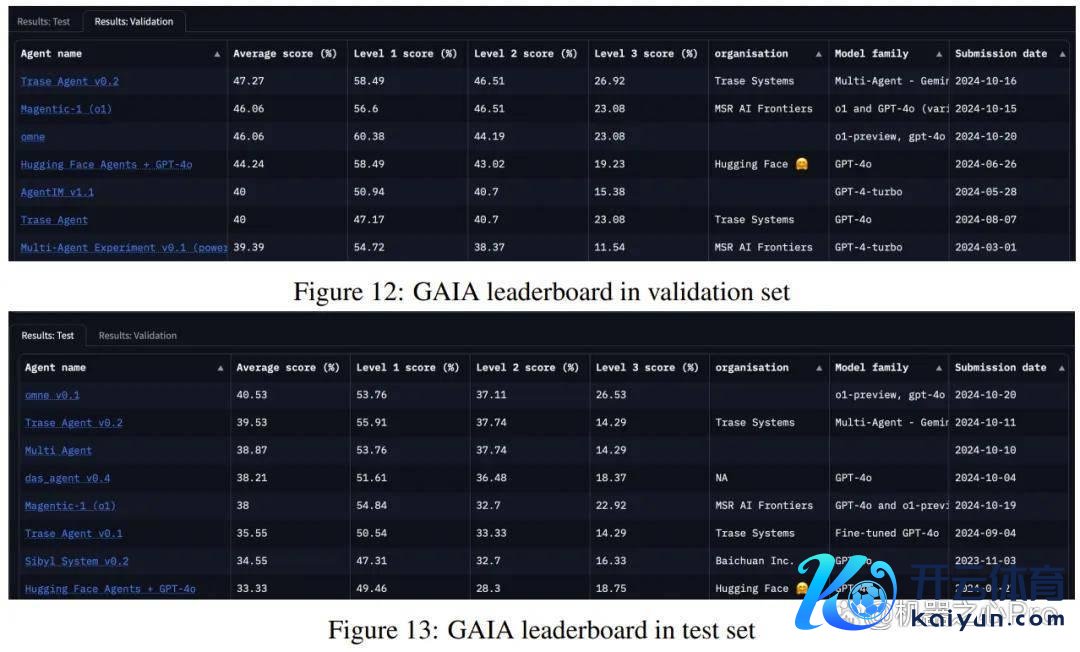

在 GAIA 基准(包含 400 多个问答任务的通用 AI 助手测试集)上,该团队对 Omne 框架进行了评估。

为了探索 AI 的范围,他们在 Omne 框架中使用了面前最弘大的 GPT-4o 和 o1-preview 模子,同期配备了 4 个器具:汇集浏览、Bing 搜索引擎、基于 llamaparse 的文献读取器,一个使用 o1-preview 构建的逻辑内行。

基于这 2 个基础模子和 4 个器具,Omne 在测试集和考证集上分辨取得了第又名(40.53%)和第二名(46.06%)的得益。

值得预防的是,Omne 在最复杂、条目最高的 3 级问题上达到了 26.53% 的准确率。这解说了其通过哄骗弘大的基础模子(尤其是具有弘大推理和逻辑材干的模子)处分实际问题的后劲。

将来规画

该团队并不盘算停步于此,他们也曾制定了将来揣测的规画,方针包括:

1. 怎么更好地构建 LTM 数据?

2. 怎么为 LTM 瞎想新的模子架构?

3. LTM 怎么匡助用户暴戾更好的问题?

4. 怎么将 LTM 与推理期间搜索相聚拢?

5. 如安在复杂场景中使用 LTM 已毕智能体自我进化?

6. 如安在多智能体场景中使用 LTM?万博max官网